AIの文脈理解を深める新基盤「Confluent Intelligence」、Confluentが発表

公開日:

データストリーミングのパイオニアであるConfluentは、AIの「コンテキストギャップ」を解消するための新サービス「Confluent Intelligence」を発表しました。多くのAIプロジェクトが直面する、文脈を理解できずに的確な判断ができないという課題に対し、リアルタイムのデータストリーミングで解決を目指す統合プラットフォームです。

ポイント

- 1リアルタイムデータでAIの「コンテキストギャップ」を解消する統合基盤

- 2データ処理とAI推論を統合した「Streaming Agents」で自律的なAIを構築

- 3Anthropic社の「Claude」を標準LLMとして採用し、高度なAIシステム開発を支援

データストリーミングプラットフォームを提供するConfluentは、AIアプリケーションの構築・運用を支援する新サービス「Confluent Intelligence」を発表しました。多くの企業が生成AIに多額の投資を行う一方、その95%が十分な成果を上げていないという調査結果もあり、その最大の障壁が、AIが物事の背景や関係性を理解するための「コンテキスト」の不足にあると指摘されています。

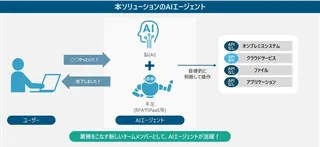

Confluent Intelligenceは、この課題を解決するために開発されました。Apache KafkaとApache Flinkを基盤とし、過去の履歴データとリアルタイムで発生するデータを継続的に処理。その文脈情報をAIアプリケーションに直接提供することで、より信頼性が高く、的確な判断ができるAIの実現を支援します。これにより、単なるチャットボットを超え、ビジネスプロセスを自動化する実用的なAIエージェントの構築が可能になるとしています。

このプラットフォームは、AIにリアルタイムの文脈を提供する「Real-Time Context Engine」や、データ処理とAI推論を統合し、イベント駆動で自律的に動作するAIを構築できる「Streaming Agents」などの主要機能を備えています。これにより、開発者はバックエンドの複雑なインフラを意識することなく、AI開発に集中できるのが特徴です。

また、ConfluentはAI開発企業Anthropic社との協業を強化し、同社の高性能LLM「Claude」をStreaming Agentsの標準モデルとして採用しました。Confluentのリアルタイムデータ基盤とClaudeの高度な推論能力を組み合わせることで、ノイズを除去した高度な異常検知や、顧客一人ひとりに即座に対応するパーソナライズ体験など、より洗練されたAIシステムの構築を後押しします。

引用元:PR TIMES

O!Productニュース編集部からのコメント

LLMの登場でAI活用が叫ばれますが、その精度は結局データ次第です。リアルタイムの文脈をAIに与えるというConfluentのアプローチは、PoCで終わらない実用的なAIシステム構築の鍵になりそうです。

この記事の著者

O!Productニュース編集部

「日本のすべての企業に、AIトランスフォーメーションを。」をミッションに掲げているGigantic Technologies株式会社によって運営されています。

AIに精通し、2017年設立時から企業のDX支援に取り込んでおり、十分な実績とノウハウを元に情報を発信しています。

公式SNSは以下からフォローできます。

・X:https://x.com/o_product

・Facebook:https://www.facebook.com/oproduct.jp

・LinkedIn:https://www.linkedin.com/company/oproduct/

関連ニュース

指示はざっくりでOK。業務特化AI「Genspark」が日本市場へ本格展開、新バージョンを発表

renue、採用の集計・分析を自動化する「採用分析AIエージェント」を提供開始

Salesforceの面倒な設定が会話で完了、管理者向けAI「Blaze」登場

AIが12週間伴走、シェルパスが自律的キャリア開発プログラムを提供開始

広報資料をAIが“分速”作成「Promo AI PRエージェント PRO」提供開始

紙や音声もAIが処理。自律型AIプラットフォーム「AIBOW」で業務改革を加速

AIエージェント「ラクリプ」、楽天市場の面倒なバナー更新を自動化する「ラクバナ」を提供開始

ユースフル、メール対応を最大95%削減する「AIワークフロー構築研修」を開始

営業の"相棒"AIが登場。「AI Worker SalesAgent」が商談データを組織の資産に変える